BTC/HKD-0.27%

BTC/HKD-0.27% ETH/HKD-0.77%

ETH/HKD-0.77% LTC/HKD+0.37%

LTC/HKD+0.37% ADA/HKD-0.28%

ADA/HKD-0.28% SOL/HKD-1.24%

SOL/HKD-1.24% XRP/HKD-0.88%

XRP/HKD-0.88%來源:量子位

從Meta的LLaMA發展出的羊駝家族一系列大模型,已成為開源AI重要力量。

但LLamA開源了又沒全開,只能用于研究用途,還得填申請表格等,也一直被業界詬病。

好消息是,兩大對標LLaMA的完全開源項目同時有了新進展。

可商用開源大模型來了,還一下來了倆:

MosaicML推出MPT系列模型,其中70億參數版在性能測試中與LLaMA打個平手。

Together的RedPajama系列模型,30億參數版在RTX2070游戲顯卡上就能跑。

國盛證券分析師:國際央行研發數字貨幣主要受兩大現象推動:國盛證券分析師宋嘉吉認為,國際央行研發數字貨幣主要受到兩大現象推動,一是現金使用率下降,央行擔心公眾無法得到央行負債,例如瑞典央行、加拿大央行;二是私人部門發行的數字貨幣崛起,各國央行擔心法幣受沖擊,例如英國央行。此外,宋嘉吉表示,英、美、加、日等大國現金使用率并未下降到“臨界點”,現有的貨幣政策體系也較為有效,它們不認為有必要發行CBDC。(澎湃新聞)[2020/10/9]

對于這些進展,特斯拉前AI主管AndrejKarpathy認為,開源大模型生態有了寒武紀大爆發的早期跡象。

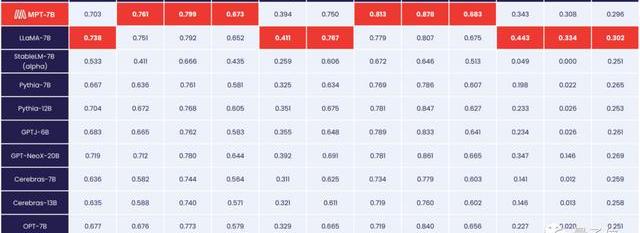

MPT,與LLaMA五五開

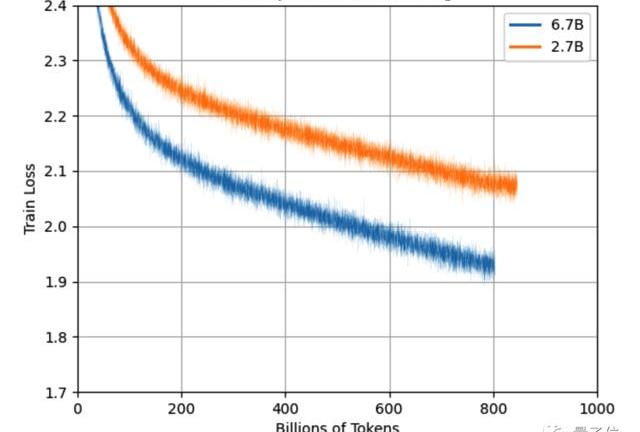

MPT系列模型,全稱MosaicMLPretrainedTransformer,基礎版本為70億參數。

OKEx徐坤:印度市場大有可為 已與當地兩大頭部交易所建立合作:今日,針對“印度最高法院取消印度央行針對加密貨幣的禁令”的消息,徐坤表示,印度市場具有巨大的互聯網人口紅利,網民接近6億,而印度盧比通脹嚴重,民眾對于兼具支付功能與價值存儲功能的加密貨幣的需求一直很強。之前因為政策原因,場內交易受限,但場外購買比特幣的熱度一直很高,日交易量有數百萬美元,這是一個非常值得拓展的市場。年初,OKEx已與印度兩大頭部交易所CoinDCX和BitBns建立合作關系,印度也是OKEx全球化布局中的重要部分。[2020/3/4]

MPT在大量數據上訓練,與LLaMA相當,高于StableLM,Pythia等其他開源模型。

支持84ktokens超長輸入,并用FlashAttention和FasterTransformer方法針對訓練和推理速度做過優化。

在各類性能評估中,與原版LLaMA不相上下。

聲音 | Genesis首席執行官:機構資金涌入加密領域尚有兩大障礙需要消除:Genesis首席執行官Michael Moro近期接受采訪時表示,雖然他相信機構資金將大量涌入加密領域,但仍有一些障礙需要消除。這些障礙包括監管缺乏明確性,以及與傳統資產爭奪同一投資者資金池的挑戰。此外,他還表示,加密交易仍然需要更加規范。金融機構“在思想上很難理解這個想法”。但隨著Square、富達(Fidelity)和Facebook等公司開始推出產品,加密交易將變得更易被接受,而不再像以前那樣神秘和陌生。”Moro還提出,雖然數字貨幣是一種新的資產類別,但和傳統資產一樣,“都在追逐同樣的投資者資金池。”他解釋稱:“加密領域試圖吸引的資金池其實就是來自那些投資投資股票、債券和黃金等傳統資產的捐贈基金、對沖基金和家族辦公室,正因為如此,我總覺得加密技術的投資者想要的是與其他市場相同的產品和服務。所以這里還有一個巨大的空白需要填補。”(Seeking Alpha)[2019/10/17]

聲音 | Algorand創始人:區塊鏈不可能三角已可解決,Algorand 擁有兩大核心優勢:據Algorand Official消息,Algorand創始人Silvio Micali教授近日表示,區塊鏈的三難困境意味著組成區塊鏈的三個要素,安全性,可擴展性和去中心化不能同時實現。但是Algorand通過純權益證明共識算法解決了這個難題。Algorand的另一個優勢是它對原子交換的支持。原子交換是指基于不同區塊鏈的加密貨幣交換。現有的原子交換是通過哈希時間鎖定技術進行的,該技術可設置時間并在當時未更改加密貨幣的情況下取消交易。Algorand區塊鏈證明資產存在于不同的區塊鏈中,可以直接交易。[2019/10/2]

除了MPT-7BBase基礎模型外還有三個變體。

MPT-7B-Instruct,用于遵循簡短指令。

MPT-7B-Chat,用于多輪聊天對話。

MPT-7B-StoryWriter-65k+,用于閱讀和編寫故事,支持65ktokens的超長上下文,用小說數據集微調。

MosaicML由前英特爾AI芯片項目Nervana負責人NaveenRao創辦。

該公司致力于降低訓練神經網絡的成本,推出的文本和圖像生成推理服務成本只有OpenAI的1/15。

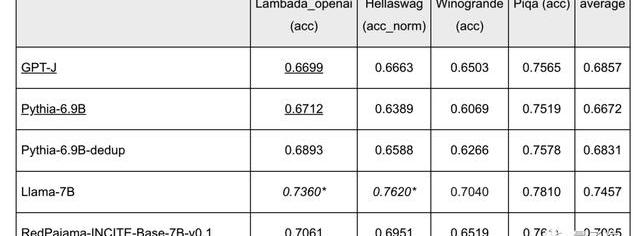

RedPajama,2070就能跑

RedPajama系列模型,在5TB的同名開源數據上訓練而來。

除70億參數基礎模型外,還有一個30億參數版本,可以在5年前發售的RTX2070游戲顯卡上運行。

目前70億版本完成了80%的訓練,效果已經超過了同規模的Pythia等開源模型,略遜于LLamA。

預計在完成1Ttokens的訓練后還能繼續改進。

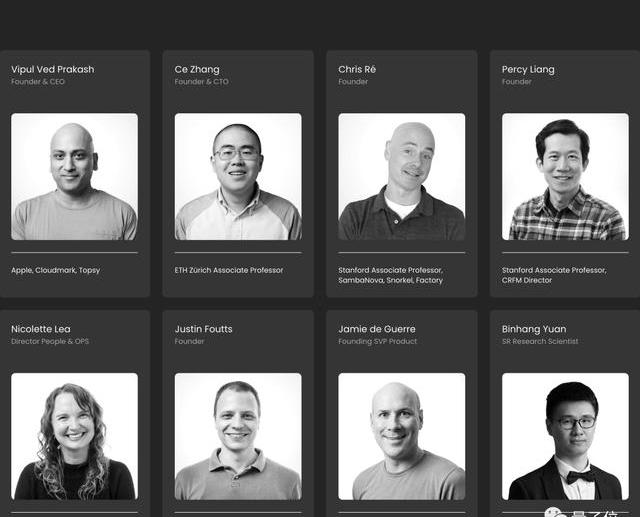

背后公司Together,由蘋果前高管VipulVedPrakash,斯坦福大模型研究中心主任PercyLiang,蘇黎世聯邦理工大學助理教授張策等人聯合創辦。

開源模型發布后,他們的近期目標是繼續擴展開源RedPajama數據集到兩倍規模。

OneMoreThing

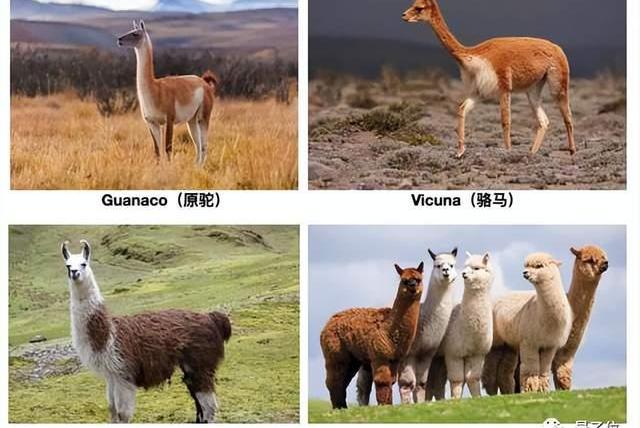

來自南美洲的無峰駝類動物一共4種,已被各家大模型用完了。

Meta發布LLaMA之后,斯坦福用了Alpaca,伯克利等單位用了Alpaca,JosephCheung等開發者團隊用了Guanaco。

以至于后來者已經卷到了其他相近動物,比如IBM的單峰駱駝Dromedary,Databricks的Dolly來自克隆羊多莉。

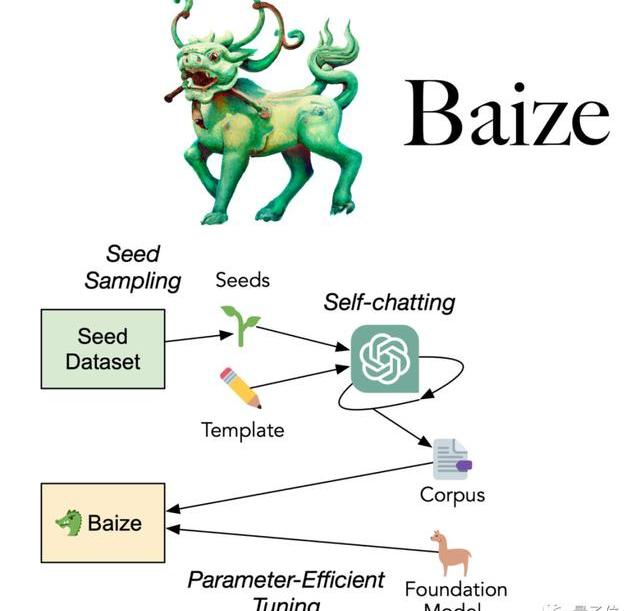

國人研究團隊也熱衷于用古代傳說中的神獸,如UCSD聯合中山大學等推出的白澤。

港中文等推出的鳳凰……

最絕的是哈工大基于中文醫學知識的LLaMA微調模型,命名為華駝。

參考鏈接:

https://www.mosaicml.com/blog/mpt-7b

https://www.together.xyz/blog/redpajama-models-v1

https://twitter.com/karpathy/status/1654892810590650376?s=20

2022年,無疑是中心化交易所的至暗時刻。FTX暴雷,這讓傳統世界對于中心化的交易所,甚至是區塊鏈失去了信任.

1900/1/1 0:00:00作者|?AndrewHayward編譯|PANews5月3日,SuiNetwork主網正式上線,但在這一里程碑事件之前,一個活躍的NFT社區已經在這個新興區塊鏈上扎根.

1900/1/1 0:00:00來源:VR陀螺 作者:元橋 圖片來源:由無界AI工具生成VR一直都以輕量化內容為主,缺重度內容已久.

1900/1/1 0:00:00NFT作為可以代表獨一無二的數字資產或實物資產的加密代幣,它在區塊鏈上具有唯一性和不可替代性。NFT在以太坊等智能合約平臺上已經發展了多年,誕生了許多著名的項目和應用.

1900/1/1 0:00:00原文標題:《EthereumL1zkEVM》原文作者:polynya,以太坊研究員原文編譯:Kate,Marsbit似乎有一種普遍的誤解,認為以太坊只能通過L2進行擴展.

1900/1/1 0:00:00DAO在加密領域獲得了極大的關注和投資,其中有幾個DAO在各自的國庫中管理著數十億美元。然而,并不是所有DAO的參與者都有著高尚的目的.

1900/1/1 0:00:00